人工智能推理解读:机器学习模型如何从训练走向生产

2025年9月29日

如果你最近花过时间接触人工智能,那么你可能听过“推理”这个词,它尤其在关于人工智能芯片、延迟或扩展性的谈话中浮现。但这到底是什么意思呢?

简单来说,推理就是人工智能将其训练付诸实践的时刻。每当人工智能系统接受新的输入——比如一个问题、一幅图像或一个声音——并生成输出时,就会发生推理。

这是将机器学习转变为有用事物的无形过程,无论是Chat GPT回答你的问题、照片应用增强你的图片,还是你的电子邮件客户端在你看到它之前标记垃圾邮件。

让我们解析一下它是如何工作的,以及为什么这是人工智能背后默默驱动你所使用的一切的部分。

推动人工智能响应的瞬间过程

当你与人工智能模型互动时,幕后发生的事情如下,所有这一切都在毫秒内完成:

你的输入被转换为模型可以理解的数字(令牌)。

这些数字通过一个有数百万或数十亿连接的神经网络传播。

模型进行预测,计算基于其训练应该接下来是什么的概率。

这些预测被转化为输出,例如文本、一幅图像或一个你可以看到的动作。

整个过程就是推理。它不是输出本身,而是创造它的计算。这是让人工智能“活过来”的“思考”时刻。

推理比你想象的更重要

虽然训练获得了大多数头条新闻,但推理才是人工智能真正维持其价值的地方。每一次现实世界中使用人工智能的时刻,比如回答问题、生成图像、推荐歌曲,都是在推理过程中发生的。

这就是为什么它如此关键:

它定义了用户体验

当你与聊天机器人对话时,延迟会打击互动。推理越快,体验就越自然和顺畅。在自动驾驶或医学成像等应用中,即使是毫秒也可能很重要。

它驱动持续的成本

训练一个大型人工智能模型可能一次性花费数百万,但推理在用户和设备之间发生了数十亿次。这些请求很快就会累积起来。对许多人工智能公司来说,推理是最大的一项运营开支。

现在是创新发生的地方

随着模型变得越来越强大,重点已从如何训练它们转向如何有效运行它们。专用硬件(如NVIDIA GPU或定制推理芯片)和软件优化现在是人工智能创新的前沿。

将推理带到边缘

直到最近,大多数推理发生在巨大的云数据中心。但现在正在进行重大转变——边缘推理——人工智能模型直接在你的手机、笔记本电脑或智能设备上运行,而不是依靠云。

本地运行推理意味着:

更快的响应:没有互联网延迟。

更好的隐私:你的数据保留在你的设备上。

离线能力:在断开连接时仍然有效的人工智能。

由于模型优化方面的突破,人工智能变得足够轻便,可以在任何地方运行。结果是更快、更个性化、更私密的人工智能体验。

未来:将推理引入链上

随着世界越来越多地走向链上,去中心化的人工智能继续发展,一个新问题出现了:如何将推理引入链上?

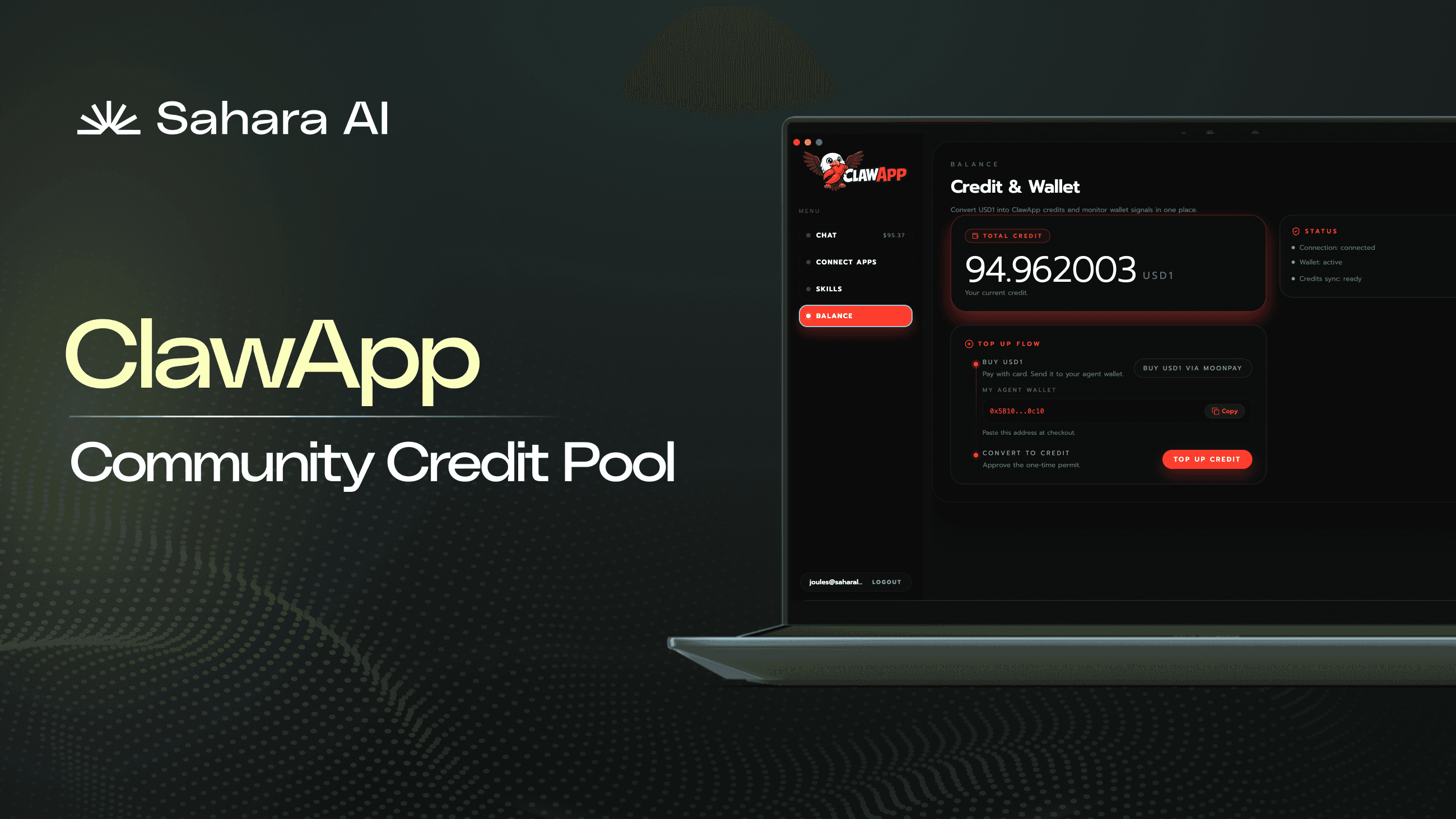

在Sahara AI,我们展望的未来是,大多数推理仍然在链外进行,以获得速度和效率,但其验证在链上进行。通过创建推理的链上证明——确认人工智能模型产生特定输出的密码学记录——我们可以在人工智能经济中建立新水平的信任和透明度。

通过Sahara AI处理的推理将在链上通过这些证明进行验证,确保真实性而不牺牲性能。

这个话题值得更深入的探讨,我们将在未来的指南中探讨它。

这只是个开始。我们会定期将复杂的人工智能主题拆解成简单的指南。在这里注册以获取每一份新指南。